大模型微调方法

来源:4-1 大模型训练与微调研发背后的数据艺术【回放】

DataSciAI

2024-01-17 11:52:36

老师,请问这里的SFT监督式微调包括了LoRA的方法吗?如果要进行LoRA微调该怎么做?

写回答

1回答

-

是的。监督包含了lora、qlora微调、P-tuning v2 、Freeze 监督微调方法。lora、qlora都是通过冻结部分参数,

然后训练自己加入的新参数,并采用低秩分解来降低参数量。

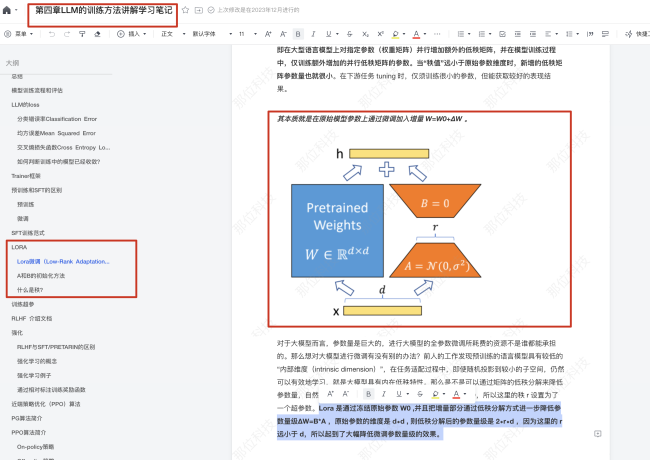

Lora通过冻结共享模型即冻结原始参数W0 ,并且把增量部分通过低秩分解方式进一步降低参数量级ΔW=B*A ,原始参数的维度是d∗d ,

则低秩分解后的参数量级是2∗r∗d ,因为这里的r远小于d,所以起到了大幅降低微调参数量级的效果。

第四章主要给大家讲方法讲原理,在第六章我们也提供了项目实战,有loar等微调代码实战模块,

可以继续学习下,整体课程内容在多个地方都会提到lora原理和微调代码实现。

包括后续我们提供langchain的理论课和langchain的代码实战课,从微调到调用大模型agent、

加载本地知识库等全流程实战,可以上手练练哈。同时除了课程直播和录播内容之外,

我们开创性的提供了课程学习笔记,可以方便大家快速复习和做为辅助学习材料,提供直播内容的基础知识和课外延伸,帮助大家理解和消化

1

1

LLM大语言模型算法特训

从入门-案例实战-多领域应用-面试指导-推荐就业,匹配课前知识路线、详细学习笔记和全方位服务,助力学习与就业,快速实现职业跃迁。附赠价值2000元+的大模型项目代码/数据和配套环境和GPU。

239 学习 · 28 问题

相似问题